Schermi tattili precisi grazie all'IA

Meno errori di battitura quando si tocca la tastiera di uno smartphone: Gli informatici dell'ETH di Zurigo hanno sviluppato una nuova soluzione di intelligenza artificiale che consente agli schermi tattili di riconoscere i tocchi con una risoluzione otto volte superiore. Inoltre, è in grado di dedurre con maggiore precisione il punto in cui le dita toccano lo schermo.

Probabilmente ci siamo passati tutti: se si vuole digitare rapidamente un messaggio sullo smartphone, a volte si colpiscono le lettere sbagliate sulla piccola tastiera o su altri elementi dell'interfaccia utente. Questo non dipende solo da noi, perché i sensori tattili che rilevano l'input delle dita sul touch screen non sono cambiati in modo significativo dalla loro introduzione a metà degli anni 2000.

A differenza dei sensori touch, gli schermi di smartphone e tablet raggiungono oggi una qualità visiva senza precedenti, che diventa sempre più evidente con ogni nuova generazione di dispositivi: maggiore fedeltà cromatica, risoluzione più elevata, contrasto più netto. Mentre un telefono iPhone di ultima generazione, ad esempio, ha una risoluzione del display di 2532x1170 pixel, il suo sensore tattile è in grado di riconoscere solo input con una risoluzione di circa 32x15 pixel, ovvero quasi 80 volte inferiore alla risoluzione dello schermo: "E ci chiediamo perché facciamo così tanti errori di battitura sulla piccola tastiera? Pensiamo che dovremmo essere in grado di selezionare gli oggetti con una precisione al pixel tramite il tocco, ma non è così", afferma Christian Holz, l'ETH, professore di informatica del Sensing, Interaction & Perception Lab (SIPLAB), in un'intervista al sito web dell'ETH. Intervista nella serie "Spotlights del l'ETH.

Insieme al suo dottorando Paul Streli, Holz ha sviluppato un'intelligenza artificiale (AI) chiamata "CapContact" che consente di realizzare touchscreen a super-risoluzione. Questi sono in grado di riconoscere l'area di contatto tra le dita e la superficie dello schermo in modo affidabile e molto più preciso rispetto a quanto avviene oggi. Questa settimana, l'azienda ha presentato la sua nuova soluzione di intelligenza artificiale in occasione dell'evento pagina esternaCHI 2021,la conferenza specialistica sui fattori umani nei sistemi informatici.

Riconoscere dove le dita toccano lo schermo

I ricercatori dell'ETH hanno sviluppato l'intelligenza artificiale per i cosiddetti touchscreen capacitivi, ovvero il tipo di schermi presenti in tutti i nostri telefoni cellulari, tablet e computer portatili: In questi touch screen, i sensori riconoscono la posizione delle dita grazie al fatto che il campo elettrico tra le linee del sensore cambia quando un dito tocca lo schermo. I touch screen sfruttano la proprietà per cui l'intensità del "tocco" diminuisce esponenzialmente all'aumentare della distanza tra le dita. Tuttavia, non sono in grado di riconoscere l'effettivo contatto fisico con la superficie.

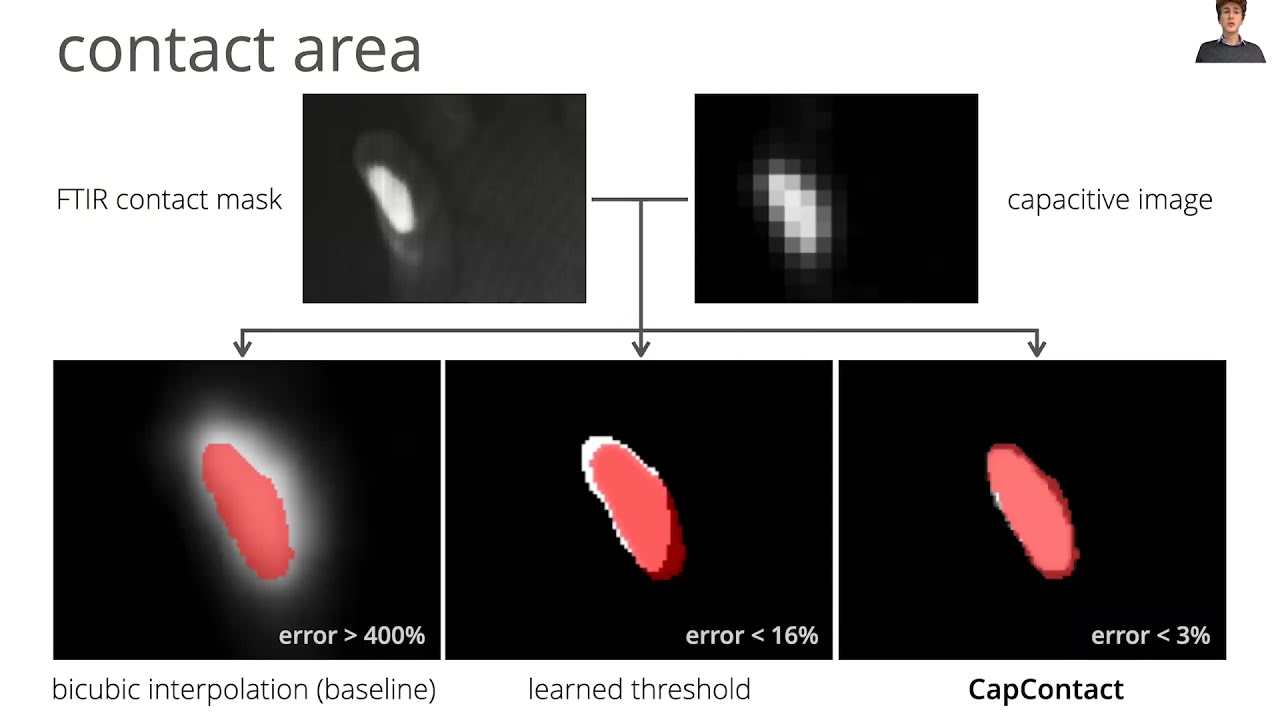

La tecnologia dei sensori capacitivi non è mai stata sviluppata per dedurre con precisione il punto in cui avviene effettivamente un tocco fisico sullo schermo, spiega Holz: "Riconosce solo la vicinanza delle nostre dita". Gli schermi tattili dei dispositivi odierni calcolano quindi la posizione in cui viene effettuato l'input con il dito da misurazioni di prossimità a risoluzione grossolana. Da un lato, i ricercatori hanno dovuto aumentare la bassa risoluzione dei sensori; dall'altro, hanno dovuto scoprire come dedurre con precisione la rispettiva area di contatto tra il dito e la superficie dello schermo dalle misurazioni capacitive.

Streli e Holz utilizzano i touchscreen come sensori di immagine, un approccio diverso da quello abituale. Secondo Holz, un touchscreen è essenzialmente una telecamera di profondità a bassissima risoluzione che può vedere a circa otto millimetri di distanza. Una telecamera di profondità non scatta direttamente foto, ma codifica la vicinanza degli oggetti nel campo visivo. Con "CapContact", i ricercatori sfruttano questa intuizione per stimare l'area di contatto fisico tra il dito e il display in alta risoluzione, utilizzando il metodo AI appena sviluppato.

In primo luogo, 'CapContact' calcola le aree di contatto effettive tra le dita e gli schermi tattili durante un tocco", spiega Holz, "in secondo luogo, calcola queste aree di contatto tra le dita e lo schermo".in secondo luogo, calcola queste aree di contatto con una risoluzione otto volte superiore a quella degli attuali sensori tattili, consentendo ai nostri dispositivi touch di riconoscere i tocchi in modo molto più preciso"."

Per addestrare l'intelligenza artificiale, i ricercatori hanno sviluppato un dispositivo speciale che registra le intensità capacitive, cioè i tocchi ravvicinati, e le mappe di contatto reali utilizzando un sensore di pressione ad alta risoluzione. Registrando i tocchi reali di molti partecipanti al test, i ricercatori hanno ottenuto dati di addestramento con i quali "CapContact" ha imparato a prevedere le superfici di contatto con una super-risoluzione a partire dai dati grossolani e a bassa risoluzione dei sensori degli attuali touchscreen.

La bassa risoluzione come fonte di errore

"Nel nostro articolo dimostriamo che possiamo ricavare la posizione dell'input tattile in modo molto più preciso dall'area di contatto tra il dito e lo schermo del cellulare calcolata da 'CapContact' rispetto a quanto riescono a fare i dispositivi attuali", aggiunge Paul Streli. I ricercatori hanno anche dimostrato che un terzo degli errori nei dispositivi attuali è dovuto al fatto che la scansione dell'input viene effettuata solo a bassa risoluzione. "CapContact" elimina questi errori grazie all'apprendimento automatico (deep learning).

I ricercatori hanno dimostrato che "CapContact" riconosce e separa in modo affidabile le superfici tattili anche quando le dita toccano lo schermo molto da vicino. ? il caso, ad esempio, del gesto del pizzico, quando si muovono il pollice e l'indice sullo schermo per ingrandire un testo o un'immagine. I dispositivi odierni riescono a malapena a distinguere questi tocchi. In un esperimento, i ricercatori hanno utilizzato anche sensori con una risoluzione molto più bassa rispetto a quelli installati nei telefoni cellulari di oggi: nonostante ciò, "CapContact" ha riconosciuto meglio i tocchi ed è stato in grado di dedurre le superfici di contatto in modo molto più preciso rispetto ai telefoni cellulari con la risoluzione abituale di oggi. ? quindi molto probabile che questa soluzione AI getti le basi per un nuovo riconoscimento tattile nei futuri telefoni cellulari e tablet.

Per consentire il proseguimento del lavoro sul campo, i ricercatori stanno pubblicando tutti i modelli di deep learning addestrati e i testi di partenza, nonché il dataset di addestramento registrato sul loro sito web pagina esternaPagina del progetto.

Letteratura di riferimento

Streli, P, Holz, C. CapContact: Aree di contatto a super-risoluzione da touchscreen capacitivi. CHI '21: Proceedings of the 2021 CHI Conference on Human Factors in Computing Systems, maggio 2021, Article No.: 289, Pages 1-14. DOI: pagina esterna10.1145/3411764.3445621.