La termodinamica del calcolo

L'elaborazione delle informazioni richiede molta energia. Sistemi informatici più economici dovrebbero rendere l'elaborazione più efficiente. Ma l'efficienza di questi sistemi non può essere aumentata a piacimento, come hanno dimostrato i fisici dell'ETH.

Quando nel XIX secolo si diffusero le macchine a vapore, ci si chiese subito come ottimizzarle. La teoria fisica emersa dallo studio di queste macchine, la termodinamica, si è poi rivelata un approccio estremamente fruttuoso. Ancora oggi è il concetto centrale per ottimizzare il consumo energetico delle macchine per la produzione di calore ed energia.

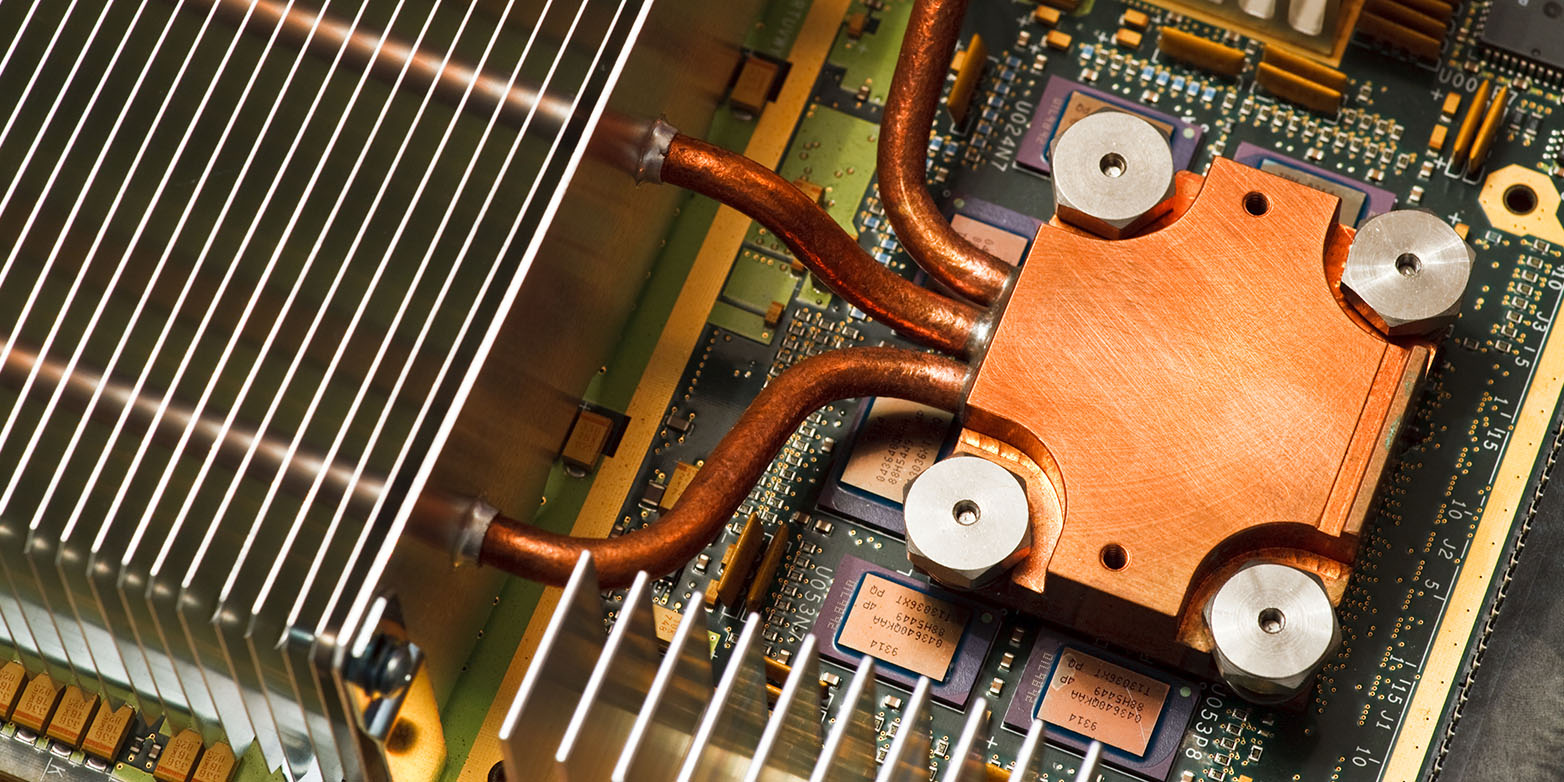

Il calore come variabile critica

La fisica e gli ingegneri sperano che questa teoria possa dare un contributo utile nell'era dell'informazione. ? sempre più chiaro che non sono più la frequenza di clock dei processori e il numero di chip utilizzati i fattori limitanti per le prestazioni dei computer, ma il consumo energetico. "Oggi le prestazioni di un centro di calcolo dipendono principalmente dalla quantità di calore che è possibile dissipare", afferma Renato Renner, professore di fisica teorica e responsabile del gruppo di ricerca sulla teoria dell'informazione quantistica.

L'affermazione di Renner può essere illustrata, ad esempio, dal boom del Bitcoin: non sono le capacità dei computer in sé, ma l'esorbitante consumo di energia, che porta a una grande produzione di calore, e i costi associati che sono diventati il fattore decisivo per il futuro della criptovaluta. Anche in altri settori, la fame di energia dei computer è ora un fattore di costo significativo.

Per l'elaborazione delle informazioni, la questione di come le operazioni di calcolo possano essere eseguite nel modo più efficiente possibile da un punto di vista termodinamico sta quindi diventando sempre più urgente - o in altre parole: come è possibile eseguire il maggior numero di operazioni di calcolo con la minor quantità di energia possibile? Come per le macchine a vapore, i frigoriferi e le turbine a gas, anche in questo caso è in gioco un principio fondamentale: è possibile aumentare l'efficienza a piacimento o esiste un limite fisico che non può essere superato per motivi di principio?

Collegare due teorie

Per l'ETH la risposta è chiara: questo limite esiste davvero. Insieme al suo dottorando Philippe Faist, che ora lavora come postdoc al Caltech, ha dimostrato in un articolo in corso di pubblicazione sulla rivista "Physical Review X" che l'efficienza dell'elaborazione delle informazioni non può essere aumentata a piacimento - e non solo nei centri dati quando si calcolano le previsioni del tempo e la potenza di calcolo. non solo nei centri di calcolo delle previsioni del tempo e nell'elaborazione dei pagamenti in entrata, ma anche in biologia, ad esempio nella conversione delle immagini nel cervello o nella riproduzione delle informazioni genetiche nelle cellule. I due fisici mostrano anche quali sono i fattori decisivi che sono responsabili della limitazione.

"Il nostro lavoro collega due teorie che a prima vista sembrano non avere nulla a che fare l'una con l'altra: la termodinamica, che descrive la conversione del calore in lavoro meccanico, e la teoria dell'informazione, che si occupa delle leggi dell'elaborazione delle informazioni", spiega Renner.

Il fatto che esista una connessione tra le due teorie può essere inizialmente supposto da una curiosità formale: Nella teoria dell'informazione esiste un termine matematico formalmente simile alla definizione di entropia in termodinamica. Questo è il motivo per cui il termine entropia viene utilizzato anche nella teoria dell'informazione. Renner e Faist sono ora riusciti a dimostrare che questa somiglianza formale è apparentemente più profonda di quanto si possa inizialmente sospettare.

Nessun limite fisso

? notevole che il limite di efficienza con cui le informazioni possono essere elaborate non sia apparentemente fisso, ma possa essere influenzato: Quanto meglio si comprende un sistema, tanto più precisamente si può adattare il software al design del chip, ad esempio, e tanto più efficientemente si possono elaborare le informazioni. Questo è esattamente ciò che si fa oggi nel settore dei supercalcolatori. "In futuro, i programmatori dovranno considerare anche la termodinamica del calcolo", è convinto Renner. "Il fattore decisivo non è ridurre al minimo il numero di operazioni di calcolo, ma utilizzare algoritmi che consumino meno energia possibile".

Anche i sistemi biologici potrebbero servire da punto di riferimento per gli sviluppatori: "Sappiamo da vari studi che i nostri muscoli funzionano in modo molto efficiente dal punto di vista termodinamico", spiega Renner. "Ora, naturalmente, sarebbe interessante sapere quanto bene si comporta il nostro cervello quando elabora i segnali".

Il più vicino possibile all'optimum

Non è un caso che Renner, in quanto fisico quantistico, si occupi di queste questioni: la termodinamica quantistica è un nuovo campo di ricerca emerso negli ultimi anni ed è particolarmente rilevante per la costruzione di computer quantistici. "Sappiamo che i qubit che verranno utilizzati nei futuri computer quantistici devono operare vicino all'optimum termodinamico per ritardare la decoerenza", riferisce Renner. "Questo fenomeno è un problema importante nella costruzione dei computer quantistici perché impedisce di mantenere gli stati di sovrapposizione della meccanica quantistica abbastanza a lungo da poter essere utilizzati per le operazioni di calcolo".

Riferimento alla letteratura

Faist P, Renner R: Costo di lavoro fondamentale dei processi quantistici. Physical Review X, 2018, doi: pagina esterna10.1103/PhysRevX.8.021011