Calculer pour le climat (partie 1) : ?volution des modèles

Depuis toujours, l'homme nourrit le désir de pouvoir prédire le temps qu'il fera. Avec un peu d'expérience dans l'interprétation des signes météorologiques, il a certes toujours été possible de faire des prévisions à court terme. Mais les prévisions météorologiques à plusieurs jours - et les simulations du climat futur - ne sont possibles que depuis quelques décennies.

Les prévisions du temps et - à plus grande échelle - du climat sont un processus complexe. Pour ce faire, des observations locales et globales actuelles sont intégrées dans des programmes informatiques spécialisés, qui modélisent ensuite les conditions météorologiques futures. Les résultats de telles simulations ne sont pas seulement importants pour les bulletins météorologiques quotidiens ; ils apportent également des réponses aux questions relatives au changement climatique, notamment en ce qui concerne l'adaptation (comment devons-nous gérer le climat futur ?) et les mesures de protection (comment pouvons-nous atténuer le changement climatique ?).

Le mathématicien et météorologue britannique Lewis F. Richardson a tenté de "calculer" le temps dès 1917. Sa puissance de calcul était constituée d'un effectif imaginaire de 64 000 personnes, qui représentaient ensemble le premier "ordinateur" massivement parallèle. Richardson a développé un vaste ensemble de tableaux qui servaient de simple mémoire distribuée (chaque "ordinateur" devant saisir les chiffres à la main). Il s'est également penché sur la parallélisation, la communication et la synchronisation, autant de thèmes centraux de la simulation climatique moderne.

Une question de résolution

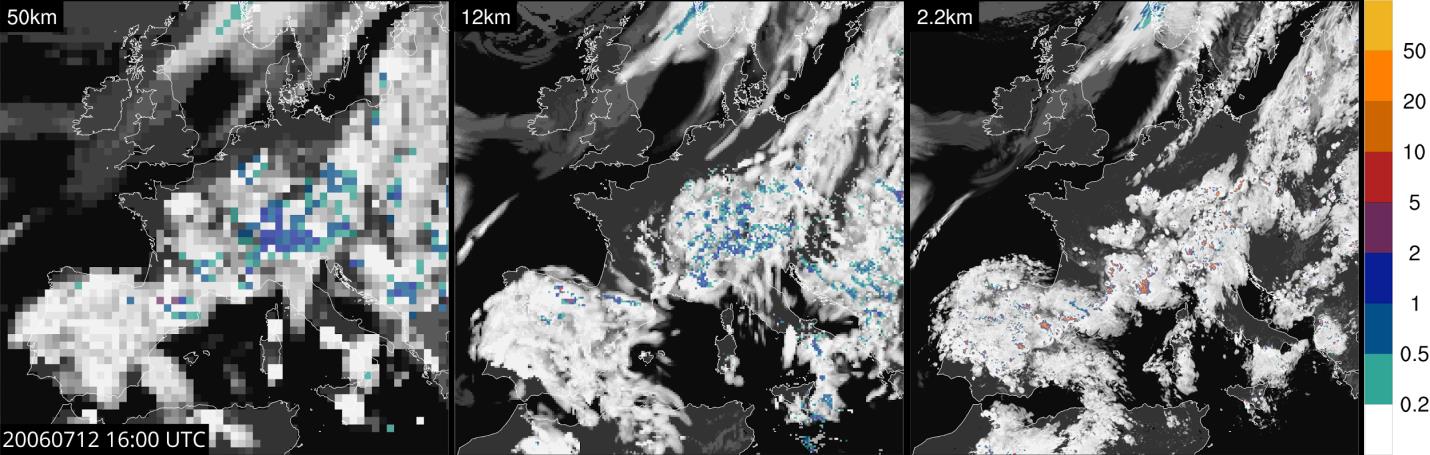

Richardson représentait déjà l'atmosphère à l'aide d'une grille de calcul tridimensionnelle afin de résoudre une forme simplifiée des équations fluido-dynamiques sur une planète en rotation - c'est-à-dire de calculer le temps qu'il fait - de manière très similaire à ce que nous faisons aujourd'hui. Les premières simulations réalistes n'ont toutefois été réalisées que plus tard, dans les années 50. A l'époque, on travaillait encore avec une résolution d'environ 800 km. Une grande percée a été réalisée à la fin des années 70, lorsque la résolution des modèles globaux a été affinée à environ 100 km. Cela a permis de faire des prévisions météorologiques à cinq jours, car on pouvait pour la première fois traiter de manière adéquate les systèmes de haute et basse pression. Avant cela, les prévisions n'étaient possibles que pour un jour.

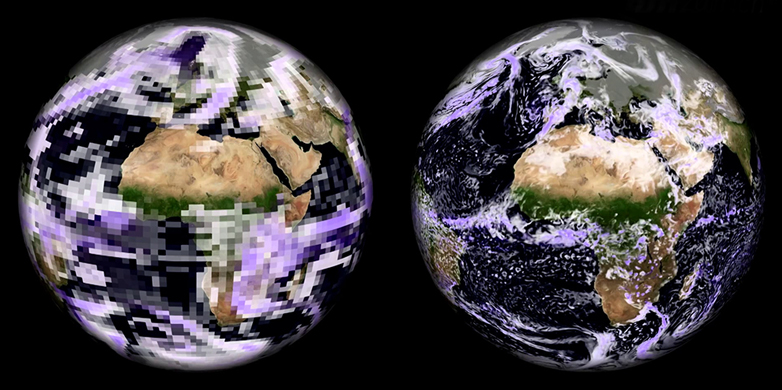

Aujourd'hui, nous sommes confrontés au prochain défi : à partir d'une résolution de 1 km, il devient possible de représenter clairement les nuages convectifs (qui provoquent des orages et des averses). Nous représentons désormais la dynamique de ces systèmes atmosphériques à échelle fine par des lois physiques et non plus, comme auparavant, par des méthodes d'approximation semi-empiriques. De telles simulations au kilomètre près sont déjà utilisées dans la prévision météorologique opérationnelle et de plus en plus dans la recherche climatique. De nombreuses études montrent qu'elles permettent de représenter de manière adéquate le cycle de l'eau et ses phénomènes extrêmes. On espère en outre que la résolution au kilomètre près augmentera la précision des modèles climatiques. Les résultats récents d'une simulation sur l'Europe [1] illustrent les avantages d'une haute résolution et étayent ces perspectives d'avenir (voir illustration).

Ces simulations ont été réalisées à l'aide du modèle COSMO [2]. COSMO est un programme informatique complexe développé par des centaines de chercheurs en collaboration internationale pendant des décennies. Le programme fonctionne sur des supercalculateurs et comprend plus de 300'000 lignes de code source. Il est utilisé par de nombreux centres météorologiques européens - y compris MétéoSuisse - ainsi que par environ 200 scientifiques dans différentes universités et centres climatiques, comme le Center for Climate Systems Modelling. C2SM à l'ETH Zurich.

Développer de meilleurs modèles de calcul

Les supercalculateurs, également appelés "superordinateurs", exploitent les possibilités de ce que nous pouvons calculer. Pour ce faire, ils utilisent des processeurs multic?urs spécialisés et des processeurs graphiques (GPU). Atteindre une performance maximale sur de tels systèmes massivement parallèles est un défi majeur en informatique. La spécialisation permet en outre d'économiser beaucoup d'argent et d'énergie : En passant à une architecture hétérogène basée sur des GPU dans le système Piz-Kesch [3], le service météorologique suisse MétéoSuisse a par exemple pu améliorer l'efficacité énergétique de ses prévisions opérationnelles d'un facteur supérieur à trois. Ce moteur de calcul est désormais utilisé pour les prévisions météorologiques quotidiennes.

Pourtant, programmer efficacement des systèmes informatiques hétérogènes reste un défi de taille - de nouvelles connaissances et de nouveaux outils sont nécessaires pour y parvenir. L'architecture GPU suit des principes de conception complètement différents de ceux des processeurs traditionnels et oblige le programmeur à exprimer le parallélisme massif dans un langage spécialisé tel que CUDA. Cela diffère fondamentalement de la manière dont nous avons écrit du code au cours des 30 dernières années. Mon groupe, le "Scalable Parallel Computing Laboratory". SPCL, veut encore augmenter les performances obtenues et travaille sur des méthodes permettant de programmer des supercalculateurs hétérogènes à haute échelle dans le cadre du projet "Platform for Advanced Scientific Computing" (PASC) [4]. PASC a pour objectif de moderniser le calcul à haute performance (CHP) en Suisse. Les résultats sont discutés lors de la conférence annuelle du même nom. [5]

Torsten Hoefler a rédigé ce billet de blog en collaboration avec Christoph Sch?r (ETH Zurich) et Oliver Fuhrer (MétéoSuisse). Dans leur prochain article, "Calculer pour le climat (partie 2)", les auteurs expliquent le fonctionnement des modèles climatiques modernes.

Informations complémentaires

[1]Leutwyler, D., O. Fuhrer, X. Lapillonne, D. Lüthi, C. Sch?r, 2015 : Continental-Scale Climate Simulation at Kilometer-Resolution. ETH Zurich ressource en ligne. c?té externeShort description and animation, Climate Science Visuals : c?té externeVidéo en ligne.

[2] c?té externeCOSMO modèle